Monitoreo a las redes y la generación distribuida, una nueva herramienta

La integración de las comúnmente denominadas energías renovables, en combinación con las redes inteligentes, han detonado una serie de alertas ante la aparición de problemas hasta hoy desconocidos, y que si no son entendidos y modelados se convertirán en un problema importante para todos los usuarios de energía eléctrica del país

Por Roberto Figueroa Cerritos

Tomando en cuenta que, a nivel país, los términos calidad de energía o calidad de suministro son más comunes en los ámbitos industriales y comerciales, tiene varios años que sectores como los centros de datos y la industria altamente automatizada son conscientes y activamente proactivos en controlar la calidad de energía en el día a día.

Estabilidad de los sistemas eléctricos de distribución

Independientemente de sus niveles de tensión y del país en el que estén instalados, el común denominador a nivel mundial en el ámbito de las redes eléctricas consistía básicamente en controles de regulación de tensión, control de la demanda con base en proyecciones a futuro basadas en mediciones históricas cada 15 minutos, revisión y control del contenido de armónicos en niveles de distribución y transmisión y el control del factor de potencia en los niveles de distribución y transmisión. La atención a problemas de transitorios de alta frecuencia o “picos” básicamente se limitaba, en lo general, a protecciones en las redes y un registro de incidencias en mediciones generales a nivel subestaciones de distribución.

El control de la frecuencia se daba por sentado en sistemas eléctricamente fuertes o robustos, con gran capacidad de generación de potencia instalada; las variaciones de frecuencia, en realidad, sólo se presentaban en sistemas débiles en generación contra la demanda del sistema.

En términos simples, se tenía que los grandes generadores de las centrales eléctricas sumaban una gran capacidad de suministrar energía por encima de los niveles demandados y que, ante ligeras fallas, la inercia de esos grandes generadores en su movimiento rotatorio sería suficiente para mantener la frecuencia (el movimiento del generador) hasta el disparo de las protecciones y salida de servicio, mientras que algún otro generador del sistema tomaba la carga sin mayor problema.

Un claro ejemplo de los efectos de un sistema eléctrico débil es el accidente de 2011 en Japón: ante la pérdida de una planta nuclear, el sistema eléctrico perdió fortaleza para mantener la estabilidad de frecuencia, como se observa en la Gráfica 1.

Las fuentes renovables de energía cambiaron la naturaleza de las redes

La topología típica de un sistema eléctrico tradicionalmente se visualizaba como grandes fuentes de generación a kilómetros de distancia de los usuarios, largas líneas de transmisión, subestaciones que disminuían la tensión a niveles de distribución para cubrir grandes espacios en ciudades de todo tamaño y transformadores para suministrar a los usuarios de baja tensión. Esto implicaba que la dirección de la energía fuera unidireccional; básicamente, de la fuente de generación se llevaba a alta tensión y de este punto la energía se despachaba a los diferentes usuarios en baja tensión, en alta tensión y en media tensión. Poco a poco, en reducidas ocasiones, se encontraron modelos de cogeneración que inyectaban excedentes a la red, pero en magnitud y contra la fortaleza de la red eléctrica no representaban problemas o riesgos grandes en el sistema.

La tecnología de medición por Sincrofasores PMU

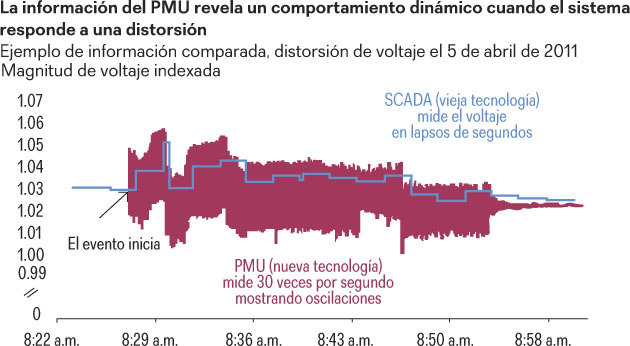

En los grandes sistemas eléctricos, uno de los retos más importantes, debido a su extensión geográfica, fue la medición entre las fuentes de generación y los puntos de entrega de las redes de transmisión, por lo que se desarrollaron sistemas de medición intercomunicados basados en SCADA, con la intención de desarrollar centros de control con sistemas de protección basados en la información recolectada por éste; sin embargo, el esquema tradicional tiene una línea de flujo muy clara. Transformadores TP Y TC: la señal se envía a un concentrador SCADA, la señal se envía a la plataforma de comunicaciones, la información llega al centro de control y, una vez procesada, regresa con las acciones que el sistema o los operadores ejecuten. Esta larga cadena de pasos suele tomar de 1 a 4 segundos en ser visible y actualizada a los operadores del centro de control, independientemente de la velocidad de muestreo del equipo de medición.

El uso de Sincrofasores en la medición ayuda a tener una mayor cantidad de información actualizada de manera más frecuente y simplificando su manejo. En la actualidad, el IEEE cuenta con una serie de estándares y recomendaciones para el manejo de la información referente a estos elementos, respecto de las características propias de los instrumentos de medición, los protocolos de comunicación, los concentradores de información y el manejo que se debe de dar a la información. Entre ellos destaca el C37.118.1-2011 y su modificación C37.118.1a-2014, donde se puede ampliar la información en esta materia.

¿Por qué son las diferencias de ángulo de fase importantes?

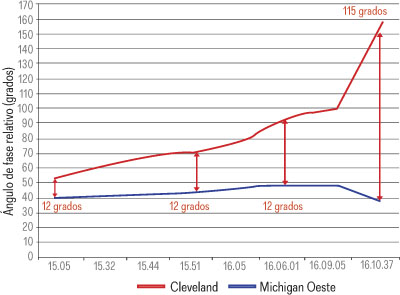

Así como en circuitos de corriente continua de potencia fluye del más alto nivel de tensión a bajas tensiones, en un sistema de alimentación de CA la energía fluye desde un ángulo de fase de tensión superior a un ángulo de fase inferior de tensión: cuanto mayor sea el diferencial de ángulo de fase entre la fuente y el lado de entrega de la carga, mayor es el flujo de energía entre esos puntos, lo que implica que la tensión estática que se ejerce a través de esa interfaz es más grande y más cerca de la proximidad a la inestabilidad del sistema completo.

Basados en este elemento, se entiende por qué en las líneas de transmisión durante las dos últimas décadas se incrementa la medición en líneas de transmisión basada en Sincrofasores, con la intención de facilitar y acercar al tiempo real el análisis de flujos de carga, estabilidad de frecuencia y estabilidad de tensión, las cuales son usadas como herramientas preventivas.

Para describir en la práctica cómo es usada esta información, se presenta un ejemplo ampliamente conocido en Estados Unidos. La Gráfica 2 muestra la diferencia de ángulo de fase de crecimiento entre Cleveland y Michigan durante el 14 de agosto de 2003, apagón en la Interconexión del Este.

Un Sincrofasor permite la medición de un valor instantáneo de la onda senoidal con una magnitud definida y un ángulo de desfasamiento respecto del tiempo. Para ser Sincrofasor debe estar ligado a un pulso denominado PPT, que en este caso es la señal recibida de la red global GPS. De esta manera, las mediciones están sincronizadas en tiempo, independientemente de su ubicación.

De manera inicial, se buscaba un promedio de 12 muestras por ciclo, que representa un elevado nivel de muestreo, lo que hace más precisas las mediciones y da una visión clara del comportamiento amplio de la red. Esta información es recolectada en concentradores de información que forman la base de datos, en un inicio utilizada para modelar sistemas eléctricos y hoy día para mantener el control del sistema y reducir la necesidad de mantener fuentes de energía operando si la demanda no lo justifica.

La generación distribuida, ¿una ventaja y un problema?

A lo largo del tiempo, la construcción de centrales generadoras representa una inversión de tal dimensión que forma parte de los planes gubernamentales y es tema de licitaciones públicas con grandes inversionistas a nivel mundial. La costumbre de construir grandes centrales generadoras de cientos de MVA en capacidad y alejadas de los centros de consumo fue durante mucho tiempo sujeta a condiciones económicas e inversiones adicionales. Para transmitir esta energía a los centros de consumo, usualmente las decisiones se basaban en la cercanía a las fuentes primarias de energía, llámense presas, minas de carbón, pozos geotérmicos, oleoductos e incluso, por seguridad, en el caso de las centrales nucleoeléctricas, sitios alejados de las ciudades y en regiones libres de sismicidad o fenómenos naturales peligrosos.

El desarrollo de los países se sujetaba a su capacidad de invertir en generación y poder construir infraestructura para llevar esta energía al consumidor, con las respectivas pérdidas en el proceso. Con el desarrollo de las llamadas energías limpias, se crean oportunidades de generación en baja escala para su consumo de manera local inicialmente en formatos ISLA o desconectados de la red, con fines de autoconsumo.

A su vez, el desarrollo tecnológico permite interconectar estos sistemas a la red pública y usarla como “banco” de energía o centro de almacenamiento, logrando que, cuando no se usa pero se produce, la energía sea entregada a la red mediante medidores bidireccionales, y cuando no hay luz solar y no se puede generar, se tome energía de la red en una bolsa energética creada con fines de facturación, pagando sólo los excedentes en el consumo o guardando por un tiempo los excedentes inyectados a la red.

En el caso de la generación eólica se ubican áreas con potencial de viento, y en algunos casos se sigue el tema de grandes campos de generación en áreas específicas, cuya energía es inyectada a la red y despachada en otro sitio, usando la energía como una bolsa de generación. Mediante el pago de un concepto llamado porteo, esta energía puede ser despachada en otro punto del sistema eléctrico usando la infraestructura existente.

El avance tecnológico termina por provocar una disminución en los costos de inversión en sistemas de generación y hace accesible a los usuarios de todo tipo invertir en generar su energía e interactuar con la red, entregando en el día y recibiendo en la noche la energía necesaria. Este punto en específico es uno de los detonantes de las llamadas redes inteligentes.

La integración de un gran número de productores en pequeño genera nuevas oportunidades de reducir pérdidas en los sistemas al evitar transmisión a grandes distancias y da flexibilidad al sistema para atender de mejor manera los requerimientos de los usuarios desde el punto de vista teórico; sin embargo, crea un reto nuevo al tener la necesidad de “administrar” un gran número de generadores que deberán de acatar las reglas de interconexión con parámetros que antes eran competencia exclusiva del suministrador público.

Las redes inteligentes, el nuevo paso

No es nuevo el hecho de que las redes inteligentes en este momento sean el centro de atención a nivel mundial. Los beneficios son prometedores para el usuario y para el suministrador, pues básicamente centran su atención en las redes de distribución de media tensión en niveles sobre los 1000 V y hasta los 65 kV, buscando la automatización de la red, con beneficios como el restablecimiento automático del servicio ante fallas en circuitos y alerta a los grupos de reparación en automático en caso de falla franca; medición en los puntos más importantes para generar el balance energético y el perfil de pérdidas de demanda y otros, a partir de información histórica detallada del usuario final, el corte remoto del sistema de prepago.

Los medidores AMI, como se conocen en México, automatizan la facturación sin requerir del ser humano en la figura de “toma de lecturas”. La predicción de la demanda y la regulación de sistemas prometen ser una de las más grandes herramientas de las redes inteligentes. Aunque en el país aún no está clara la ruta correcta, ya es posible aprovechar las bondades de la tecnología en beneficio de la calidad del suministro.

Justificación de la nueva tecnología

En el pasado, los sistemas eléctricos mantenían rigurosos cuidados en las fases de generación y transmisión, con la intención de minimizar pérdidas y llevar en aceptables condiciones de calidad de energía el suministro a los centros de consumo. Una vez en estas áreas, por medio de las redes de distribución, el objetivo primordial era entregar y facturar el servicio de energía eléctrica. En este punto, las redes de distribución fueron dotadas de protecciones y se analizaron y diseñaron para mantener niveles adecuados de regulación para minimizar en lo aceptable las pérdidas en la red, cualquiera que fuera el motivo.

Al paso del tiempo, con los restauradores automáticos se dotó de cierto grado de autonomía en la atención de cortes de suministro a la red; sin embargo, en este punto las fallas a nivel sistema eléctrico y la alta capacidad de generación, basados en máquinas rotatorias síncronas, permitían que, ante un problema en el sistema, lo robusto de la capacidad de generación permitiera mantener atendida correctamente la demanda a nivel macro.

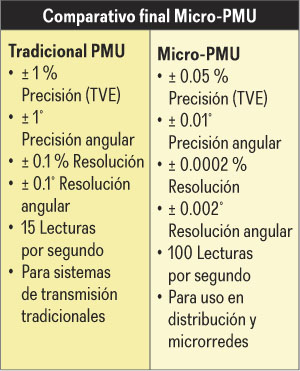

Por otro lado, las fallas no alteraban la frecuencia global del sistema ante máquinas rotatorias. Con efectos de inercia que mantenían amortizadas algunas de las fallas y un sistema fuerte y con capacidad de sobra, no le fue difícil mantener el control de la frecuencia, en este caso 60 Hz. La medición por Sincrofasores permitió tener herramientas avanzadas para el control y modelado de la red eléctrica, pero por su elevado costo esta tecnología penetra muy lentamente en el sistema.

Hoy día y en el futuro cercano, con la expansión y reducción en el costo de las energías limpias, cada vez es más notable el crecimiento del mercado, y poco a poco pasa de ser insignificante a tomar parte de la estadística nacional y mundial en producción de energía. El crecimiento es logarítmico y muy acelerado, por lo que surge cierta incertidumbre sobre cómo un sistema eléctrico reaccionará a una cantidad considerable pero atomizada de productores en pequeño interactuando con la red, tomando en cuenta, además, la llegada de los autos eléctricos y otras tecnologías modernas.

Bajo la premisa de grandes productores y medición por PMU, el sistema es administrado y las predicciones de demanda se realizan con relativa sencillez y experiencia; pero con la llegada de una gran cantidad de generadores distribuidos y con tecnologías de conmutación, ya no rotatorias, es importante enfrentar el reto y generar información y mediciones confiables y en fases iniciales ejercicios empíricos sobre modelado de las redes inteligentes.

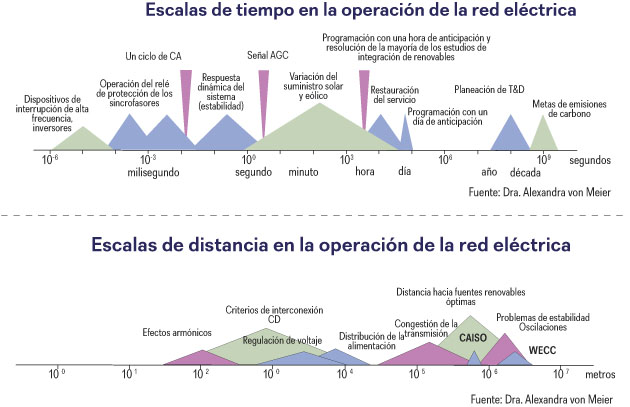

En la Gráfica 3 puede observarse, en una escala de tiempo, los tiempos de respuesta de una serie de factores relacionados con la administración de las redes eléctricas, desde el registro de huella de carbono que se estima en periodos de años, hasta el tiempo de conmutación de los elementos electrónicos que forman parte de la nueva forma de generar electricidad.

La tecnología de Sincrofasores logra, de manera realista y casi en tiempo real, administrar medir y operar un sistema eléctrico. Destaca el hecho de que hoy las variaciones de frecuencia y tensión están basadas en el tiempo de conmutación de los dispositivos electrónicos relacionados con la generación de energía eléctrica, por lo cual se requieren herramientas más precisas y rápidas para el monitoreo en tiempo real de la red. Finalmente, los Sincrofasores superaron a los sistemas SCADA y hoy se requiere algo más eficaz.

Del mismo modo, en la Gráfica 4 se observan las distancias que separan diferentes elementos de una red y el área en la que afectan diferentes fenómenos de calidad de energía o calidad de suministro. Ante este reto, nace la necesidad de crear instrumentos capaces de usar lo mejor de la tecnología y experiencia, y proporcionar las herramientas para la investigación, el modelado y el control de las redes inteligentes con generación distribuida inmersa.

En California, en Israel y en algunas universidades de Europa ya se realizan investigaciones enfocadas en la aplicación de lo que se denominó Micro Sincrofasores, y se crea el instrumento denominado PMU. Entre las principales especificaciones, se encontró que aprovechar las características y bases de la medición basada en PMU, tomando como señal de sincronización entre dos puntos de medición la señal de la red Global GPS, aseguraría el nivel de sincronización requerido para diversos puntos de medición con un alto grado de confiabilidad; sin embargo, aplicar la tecnología de transmisión a redes de distribución presenta sus particularidades únicas.

Al definir los diagnósticos de aplicación probable a las redes de distribución, se encontró que los siguientes serían el mejor punto de partida:

- Detección de islas no intencional por operación de protecciones

- Detección de fallas y su localización, incluyendo fallas de alta impedancia

- Diagnóstico de oscilación en la red de manera preventiva

- Falla inducida por recuperación retardada de tensión (FIDVR, por sus siglas en inglés) y detección de riesgos

- Detección de flujo de carga inversa

- Soporte a la red de transmisión con información detallada

- Monitoreo de generación con fuentes renovables, incluyendo información detrás del medidor convencional

- Estimación del estado real y datos reales a nivel mundial para verificación de modelos

- Y cerca de 30 aplicaciones más posibles, tomando en cuenta que esta información será aplicable también al control de la red de distribución

Entre los retos de esta tecnología, se encontró que se requiere mucha mayor precisión  y manejo de ángulos de desfasamiento menores a causa de distancias más cortas. En las fuentes de energía fotovoltaica las variaciones son más rápidas (el simple paso de nubes afecta la potencia pico). Las redes de distribución son mucho más complejas que las de transmisión, por lo que se requiere mayor revisión.

y manejo de ángulos de desfasamiento menores a causa de distancias más cortas. En las fuentes de energía fotovoltaica las variaciones son más rápidas (el simple paso de nubes afecta la potencia pico). Las redes de distribución son mucho más complejas que las de transmisión, por lo que se requiere mayor revisión.

En las redes inteligentes, el flujo de carga no es unidireccional, por lo que el concepto de flujo inverso no es del todo válido. Se debe encontrar un equilibrio en el costo beneficio, pues por los elevados costos de los PMU aún no son de uso general.

El gobierno de EUA, el estado de California y el departamento de energía generaron el proyecto ARPA-E, con un costo de más de 3 millones de dólares. Fue ejecutado por U.C. Berkeley, el Lawrence Berkeley National Lab y Power Standards Labs, consiguiendo, entre otras muchas prestaciones, que el instrumento contara con disparos para alarmas ante disturbios eléctricos, al tiempo que monitores. Esto resultó en el desarrollo del denominado PQUBE 3, que combina un monitor de calidad de energía y redes libres de software con un Micro PMU en un sólo hardware.

¿Qué hay más allá de las redes inteligentes y la calidad de suministro que está apenas manifestándose?

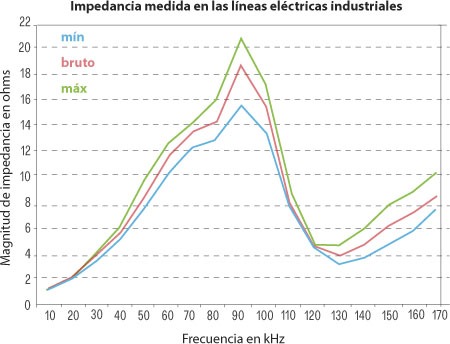

Un nuevo problema de calidad de energía está creciendo: las emisiones en la banda de 2 kHz-150 kHz o ruido, como se solía llamar. Es importante destacar que su formación tiene todo un campo conocido de ámbito técnico. La propia tecnología de la electrónica de potencia fomenta la formación de las emisiones 2 kHz-150 kHz. Se puede comparar a la “tormenta perfecta”, porque el problema de repente está creciendo y se prevé que sea aún peor.

Afortunadamente, la nueva versión del estándar internacional de compatibilidad electromagnética, enfocado en la calidad de la energía y su método de medición, la nueva IEC 61000-4-30, Ed. 3 (2015), ya contempla cómo debe de ser medido.

Existe una gran cantidad de ejemplos del mundo real. Ya está en el mercado el instrumento capaz de monitorear diariamente este fenómeno y registrarlo. Estas emisiones de 150 kHz-2 kHz se mueven a través de las líneas de la red:

- A través de cables subterráneos y el cableado en los edificios

- A través de los acoplamientos de la tecnología Power Line Carrier (PLC)

- A través de los capacitores para corrección de factor de potencia

- A través de los transformadores de alta eficiencia

- Fuentes que producen la emisión de 150 kHz-2 kHz

- Fallas o fugas de corrientes parásitas en los alimentadores de media tensión

- Emisiones forzadas y en algunos casos intencionalmente

Se debe recordar que la red de distribución se diseñó para operar en 60 o 50 Hz; sin embargo, es un hecho que conduce energía en la banda de 150 kHz-2 kHz. Cuando la impedancia máxima de una red coincide con emisiones cercanas a los 100 kHz, las emisiones de corriente se convierten en emisiones de voltaje producto de la impedancia, provocando esfuerzos innecesarios a los aislamientos de la red.

Se debe recordar que la red de distribución se diseñó para operar en 60 o 50 Hz; sin embargo, es un hecho que conduce energía en la banda de 150 kHz-2 kHz. Cuando la impedancia máxima de una red coincide con emisiones cercanas a los 100 kHz, las emisiones de corriente se convierten en emisiones de voltaje producto de la impedancia, provocando esfuerzos innecesarios a los aislamientos de la red.

En resumen

Las redes inteligentes representan una gran oportunidad para la automatización de las redes eléctricas, prometen la disminución de tiempos de interrupción por usuario y el máximo aprovechamiento de la energía generada con perfiles de demanda predictivos claros y confiables; sin embargo, los retos no terminan aún y el monitoreo remoto nuevamente sale a flote, proporcionando la información necesaria en el momento oportuno y con la precisión máxima disponible en el mercado. El viejo medidor de aguja en las subestaciones o el medidor de bajo costo, que informa voltaje y corriente más parámetros básicos, son cada vez más obsoletos en tiempos en los que la información es dinero y control.

Cuando se cree que se conocen los problemas de calidad de energía, la tecnología brinda la oportunidad de conocer las consecuencias no voluntarias del uso de la electrónica de potencia; pero, nuevamente, la medición permite contrarrestar esos efectos.

Habrá que preparar el siguiente paso y diseñar pensando en el futuro para hacer de la inversión de los clientes una inversión rentable y recuperable a corto plazo con el uso de esta información.

—————————————————————————————————————————————————–

Roberto Carlos Figueroa Cerritos

Ingeniero Electricista, con especialidad en Sistemas de Potencia, por el IPN. Certificado internacionalmente como Certified Power Quality Professional (CPQ). Ha sido conferencista en diversos congresos y foros especializados del medio eléctrico, profesor en el IPN y actualmente es director General de IMEF, SA de CV, representante de Power Standards Labs para el territorio Mexicano.